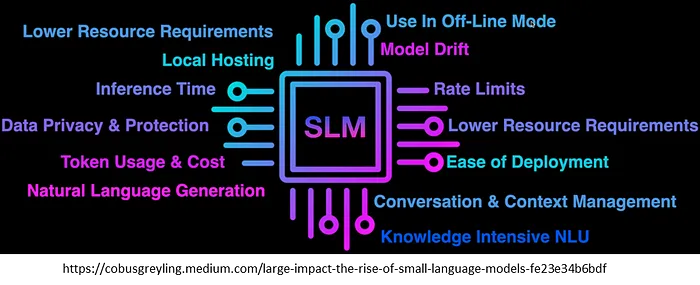

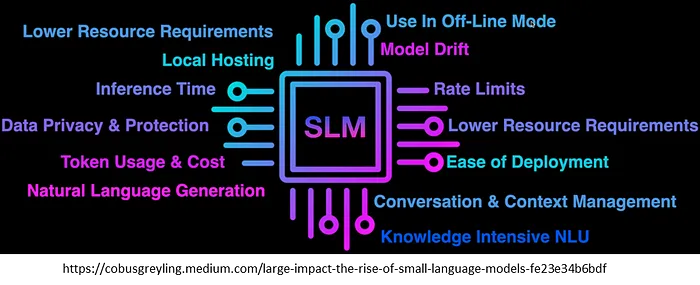

Vamos a profundizar en un tema importante en el campo de la inteligencia artificial: los Small Language Models (SLM) . Si bien la mayoría de nosotros estamos familiarizados con los Large Language Models (LLM) como GPT-4, que son increíblemente potentes y capaces, los SLM cumplen una función esencial al proporcionar alternativas más livianas y eficientes para casos de uso específicos.

Los SLM son versiones más pequeñas y eficientes de los modelos de lenguaje grandes (LLM) . Están diseñados para conservar funciones clave como la generación de texto, la clasificación y la comprensión del lenguaje, pero con una cantidad significativamente menor de parámetros. Esta reducción de tamaño hace que su ejecución sea más rápida, económica y eficiente.

- Versiones reducidas : mientras que los LLM pueden tener cientos de miles de millones de parámetros, los SLM operan con millones de parámetros.

- Menor uso de recursos : requieren menos potencia computacional, memoria y almacenamiento.

- Funcionalidades conservadas : A pesar de ser más pequeños, pueden realizar muchas de las mismas tareas que los modelos más grandes, aunque a veces con menor precisión o complejidad.

¿Por qué es esto importante?

Los SLM son ideales para situaciones en las que los recursos son limitados o donde necesitamos un rendimiento más rápido y en tiempo real. Cubren la brecha entre las altas capacidades de los LLM y las limitaciones prácticas de implementar IA en entornos con recursos limitados.

¿Por qué utilizar modelos de lenguaje pequeños (SLM)?

Quizás te preguntes, ¿por qué utilizaríamos SLM en lugar de LLM?

La razón principal: la eficiencia

Los LLM son increíblemente potentes, pero conllevan costos computacionales significativos. Requieren:

- Alto poder computacional : GPU o TPU potentes para ejecutarse de manera efectiva.

- Gran memoria y almacenamiento : para manejar su gran cantidad de parámetros.

- Alto consumo de energía : lo que puede resultar costoso y menos respetuoso con el medio ambiente.

Por otro lado, los SLM están optimizados para la velocidad y el menor consumo de recursos , lo que los hace ideales para:

- Aplicaciones en tiempo real : donde los tiempos de respuesta rápidos son cruciales.

- Computación de borde : implementación de modelos en dispositivos con capacidades de hardware limitadas.

- Soluciones Rentables : Para proyectos o empresas con limitaciones presupuestarias.

Una comparación

Consideremos los siguientes ejemplos:

Modelos de lenguaje de gran tamaño :

- GPT-4 de OpenAI : si bien el número exacto de parámetros no se revela públicamente, se sabe que es un modelo muy grande que requiere importantes recursos computacionales.

- LLaMA de Meta : viene en variantes que van desde 7 mil millones a 65 mil millones de parámetros.

- Gemini de Google : Anuncia modelos con hasta 540 mil millones de parámetros.

Pequeños modelos de lenguaje :

- GPT-4o-mini de OpenAI : aproximadamente 66 millones de parámetros.

- Microsoft Phi-3.5 : diseñado para la eficiencia en dispositivos móviles.

- Google Gemma : optimizado para aplicaciones en el dispositivo.

Como puede ver, los SLM tienen significativamente menos parámetros, lo que resulta en menores requisitos computacionales.

Comparación de referencia de los SLM

Casos de uso para modelos de lenguaje pequeños

Los SLM brillan en escenarios donde la eficiencia de los recursos es más importante que la energía bruta.

1. Computación de borde y dispositivos IoT

Los SLM son lo suficientemente livianos para funcionar en:

- Dispositivos inteligentes : como altavoces inteligentes o sistemas de automatización del hogar.

- Sistemas integrados : dispositivos con potencia de procesamiento y memoria limitadas.

- Dispositivos IoT : donde la conectividad y los recursos están limitados.

2. Aplicaciones móviles

Para interacciones en tiempo real, como:

- Asistentes virtuales en teléfonos inteligentes : Proporcionan respuestas rápidas sin procesamiento pesado.

- Comandos de voz : Interpretar y ejecutar comandos con rapidez.

- Traducción de idiomas : Traducción sin conexión sin necesidad de acceso a la nube.

3. Chatbots de atención al cliente

En muchas aplicaciones de servicio al cliente:

- Consultas predefinidas : manejo eficiente de preguntas comunes.

- Eficiencia de recursos : reducción de la carga del servidor y de los costos operativos.

- Escalabilidad : implementación en múltiples plataformas sin sobrecarga significativa.

4. Aplicaciones sin conexión para personalización

- Asistentes personales : se ejecutan completamente en el dispositivo para garantizar la privacidad y la capacidad de respuesta.

- Privacidad de datos : procesamiento de datos del usuario localmente sin enviarlos a la nube.

- Interacción en tiempo real : proporcionar experiencias fluidas y sin latencia.

Ejemplo : un asistente personal sin conexión en un teléfono inteligente que ofrece recomendaciones y respuestas personalizadas sin necesidad de conexión a Internet.

Desafíos y limitaciones de los SLM

Si bien los SLM tienen muchas ventajas, también tienen ciertas limitaciones.

1. Flexibilidad reducida y generalización de tareas

- Tareas específicas : Pueden desempeñarse bien en tareas para las que están específicamente capacitados, pero tener dificultades con otras.

- Menor adaptabilidad : no es tan bueno a la hora de manejar una amplia gama de temas o aportaciones inesperadas.

2. Dificultades con el razonamiento complejo y la comprensión contextual

- Análisis de contexto profundo : es posible que no proporcione respuestas tan precisas o detalladas como los modelos más grandes.

- Interpretación matizada : dificultad para comprender sutilezas o sarcasmo.

3. Sacrifica algo de precisión por la eficiencia

- Precisión : puede tener menor precisión en comparación con los LLM.

- Desventaja del rendimiento : la velocidad y la eficiencia se obtienen a costa de un rendimiento reducido en algunas áreas.

Estas limitaciones significan que, si bien los SLM son adecuados para muchas aplicaciones, pueden no ser ideales para tareas que requieren altos niveles de precisión, razonamiento complejo o comprensión contextual profunda.

Conclusión

En conclusión, los modelos de lenguaje pequeños ofrecen una alternativa eficiente, rentable y que requiere pocos recursos a los LLM .

- Eficiencia : Ideal para entornos con recursos computacionales limitados.

- Respuestas en tiempo real : adecuado para aplicaciones que requieren interacciones rápidas.

- Rentable : menores costos operativos en comparación con el funcionamiento de modelos grandes.

- Aplicaciones prácticas : llena un vacío importante en áreas donde los LLM son poco prácticos.