ChatGPT fue lanzado en noviembre de 2022. Desde entonces, hemos sido testigos de rápidos avances en el campo de la IA y la tecnología.

Pero sabías que el viaje de los chatbots de IA comenzó en 1966 con ELIZA? ELIZA no era tan sofisticado como los modelos de hoy en día, como GPT, pero marcó el comienzo del emocionante camino que nos llevó a donde estamos ahora.

El lenguaje es la esencia de la interacción humana, y en la era digital, enseñar a las máquinas a entender y generar lenguaje se ha convertido en una piedra angular de la inteligencia artificial.

Los modelos con los que interactuamos hoy en día, como GPT, Llama3, Géminis y Claude se conocen como modelo de lenguaje grande (LLMs). Esto se debe a que están entrenados en vastos conjuntos de datos de texto, lo que les permite realizar una amplia gama de tareas relacionadas con el lenguaje.

Pero qué son exactamente los LLM, y por qué hay tanto bombo alrededor de ellos?

En este artículo, aprenderás lo que son los LLM y de qué se trata todo el bombo.

Qué son los LLMs?

Los modelos de lenguaje grande son modelos de IA entrenados en grandes cantidades de datos de texto para entender, generar y manipular el lenguaje humano. Se basan en arquitecturas de aprendizaje profundo como los transformadores, que les permiten procesar y predecir el texto de una manera que imita la comprensión humana.

En términos más simples, un LLM es un programa informático que ha sido entrenado en muchos ejemplos para diferenciar entre una manzana y un Boeing 787 y para poder describir cada uno de ellos.

Antes de que estén listos para su uso y puedan responder a sus preguntas, los LLM están entrenados en conjuntos de datos masivos. Realistamente, un programa no puede concluir nada de una sola frase. Pero después de analizar, digamos, billones de frases, es capaz de construir una lógica para completar frases o incluso generar las suyas.

Cómo entrenar a un LLM

Aquí está cómo funciona el proceso de entrenamiento:

-

Recopilación de datos: El primer paso consiste en reunir millones (o incluso miles de millones) de documentos de texto de diversas fuentes, incluyendo libros, sitios web, documentos de investigación y redes sociales. Este amplio conjunto de datos sirve de base para el proceso de aprendizaje del modelo.

-

Patrones de aprendizaje: El modelo analiza los datos recopilados para identificar y aprender patrones en el texto. Estos patrones incluyen reglas gramaticales, asociaciones de palabras, relaciones contextuales, e incluso algún nivel de sentido común. Mediante el tratamiento de estos datos, el modelo comienza a entender cómo funciona el lenguaje.

-

Fine-Tuning: Después del entrenamiento inicial, el modelo está afinado para tareas específicas. Esto implica ajustar los parámetros del modelo para optimizar su rendimiento para tareas como traducción, resumen, análisis de sentimientos o preguntas.

-

Evaluación y Pruebas: Una vez entrenado, el modelo se prueba rigurosamente con una serie de puntos de referencia para evaluar su precisión, eficiencia y fiabilidad. Este paso asegura que el modelo funcione bien en aplicaciones del mundo real.

Una vez completado el proceso de entrenamiento, los modelos se prueban fuertemente en una serie de puntos de referencia para la precisión, eficiencia, seguridad, etc.

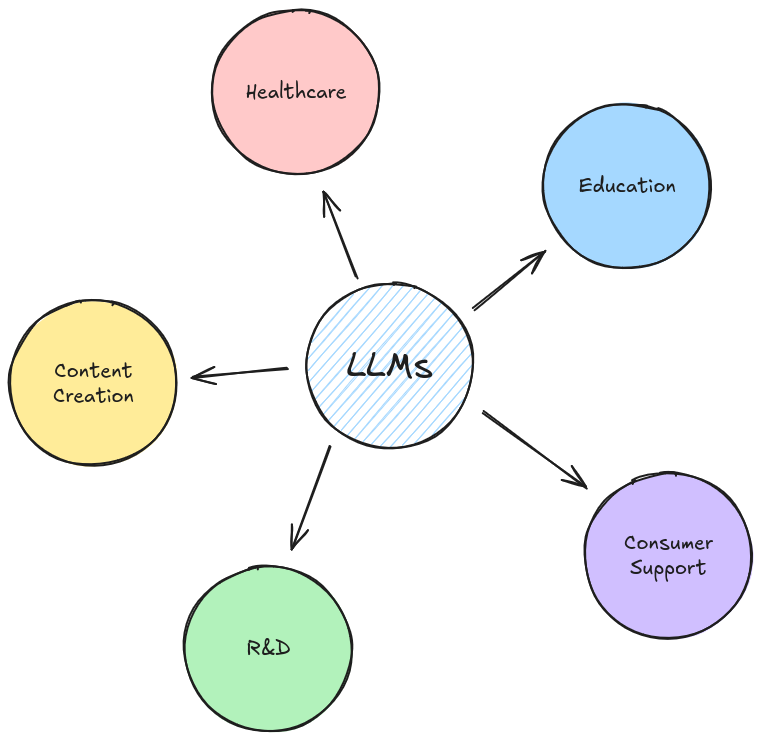

Aplicaciones de LLMs

Los LLMs tienen una amplia gama de aplicaciones, desde la generación de contenido hasta la predicción y mucho más.

Creación de contenido:

-

Asistencia para escribir: Herramitas como Gramáticamente utilizan LLMs para proporcionar sugerencias en tiempo real para mejorar la gramática, el estilo y la claridad en la escritura. Ya sea que estés redactando un correo electrónico o escribiendo una novela, los LLM pueden ayudarte a pulir tu texto.

-

Historial automatizado: Los modelos de IA ahora pueden generar contenido creativo, desde cuentos hasta novelas completas. Estos modelos pueden emular el estilo de autores famosos o incluso crear estilos literarios completamente nuevos.

Servicio al Cliente:

-

Chatbots: Muchas empresas despliegan chatbots impulsados por IA que pueden entender y responder a las consultas de los clientes en tiempo real. Estos chatbots pueden manejar una amplia gama de tareas, desde responder preguntas frecuentes hasta pedidos de procesamiento.

-

Asistentes personales: Asistentes virtuales como Siri y Alexa usan LLMs para interpretar y responder a comandos de voz, proporcionando a los usuarios información, recordatorios y entretenimiento bajo demanda.

Salud:

-

Registro médico Summarización: Los LLM pueden ayudar a los profesionales de la salud resumiendo los registros de pacientes, haciendo más fácil revisar la información crítica y tomar decisiones informadas.

-

Asistencia diagnóstica: Los modelos de IA pueden analizar los datos de los pacientes y la literatura médica para ayudar a los médicos en el diagnóstico de enfermedades y recomendar tratamientos.

Investigación y educación:

-

Revisión de la literatura: Los LLM pueden tamizar a través de grandes cantidades de artículos de investigación para proporcionar resúmenes concisos, identificar tendencias y sugerir nuevas direcciones de investigación.

-

Herramientas educativas: Los tutores de IA pueden ofrecer experiencias de aprendizaje personalizadas adaptándose a los estudiantes progreso y necesidades. Estas herramientas pueden proporcionar retroalimentación instantánea y planes de estudio a medida.

Entretenimiento:

-

Desarrollo de juegos: Los LLM se utilizan para crear personajes más dinámicos y sensibles en los videojuegos. Estos personajes impulsados por IA pueden interactuar con los jugadores de manera más realista e interactiva.

-

Generación de música y arte: Los modelos de IA ahora son capaces de componer música, generar obras de arte e incluso escribir guiones para películas, empujando los límites de la expresión creativa.

Desafíos con LLMs

Si bien los LLM son poderosos, no están exentas de sus desafíos. ChatGPT tiene más de 150 millones de usuarios mensuales, esto nos da una idea de lo grande que es el impacto de la IA. Pero las nuevas tecnologías también plantean algunos desafíos.

Ses y equidad:

- Los LLM aprenden de los datos en los que están entrenados, que pueden incluir sesgos presentes en la sociedad. Esto puede llevar a resultados sesgados o injustos en sus predicciones o respuestas. Abordar esto requiere cuidadosos ajustes de conjuntos de datos y ajustes de algoritmos para minimizar el sesgo.

Privacidad de datos:

- Los LLM pueden aprender y retener inadvertidamente información sensible de los datos en los que están entrenados, lo que plantea problemas de privacidad. Hay investigaciones en curso sobre cómo hacer LLMs más preservando la privacidad.

Recursos intensivos:

- Los LLM de formación requieren una inmensa potencia computacional y grandes conjuntos de datos, que pueden ser costosos y gravoso ambientalmente. Se están haciendo esfuerzos para crear modelos más eficientes que requieran menos energía y datos.

Interpretabilidad:

- Los LLMs son a menudo vistos como "cajas negras", lo que significa que es difícil entender exactamente cómo llegan a ciertas conclusiones. Desarrollar métodos para hacer la IA más interpretable y explicable es un área de investigación en curso.

Codificación con LLMs: Un ejemplo de replicación

Para aquellos de ustedes que les gusta ensuciarse las manos con código, aquí está un ejemplo rápido de cómo usar un LLM con la biblioteca Replicado.

Replicar es un paquete Python que simplifica el proceso de funcionamiento de modelos de aprendizaje automático en la nube. Proporciona una interfaz fácil de usar para acceder y utilizar una vasta colección de modelos preentrenados de la plataforma Replicate.

Con Replicar, puedes fácilmente:

-

Ejecute modelos directamente desde su código Python o cuadernos de Jupyter.

-

Acceda a varios tipos de modelos, incluyendo generación de imágenes, generación de texto y más.

-

Aprovecha poderosa infraestructura de nube para una ejecución eficiente del modelo.

-

Integra las capacidades de IA en tus aplicaciones sin las complejidades de entrenamiento y despliegue del modelo.

Here es un simple fragmento de código para generar texto usando el modelo de instrucciones de Meta de Meta. Llama 3es uno de los últimos modelos de lenguaje de gran código abierto desarrollado por Meta. Está diseñado para ser altamente capaz, versátil y accesible, permitiendo a los usuarios experimentar, innovar y escalar sus aplicaciones de IA.

import os

import replicate # pip install replicate

# Get your token from -> https://replicate.com/account/api-tokens

os.environ["REPLICATE_API_TOKEN"] = "TOKEN"

api = replicate.Client(api_token=os.environ["REPLICATE_API_TOKEN"])

# Running llama3 model using replicate

output = api.run(

"meta/meta-llama-3-70b-instruct",

input={"prompt": 'Hey how are you?'}

)

# Printing llama3's response

for item in output:

print(item, end="")

Explicación:

-

Primero guardamos la réplica de la ficha usando el paquete os como variable de entorno.

-

Luego utilizamos el modelo Llama3 70b-instruct para dar una respuesta basada en nuestro símbolo. Puede personalizar la salida cambiando el símbolo.

Y qué es un aviso? Un aviso es esencialmente una instrucción basada en texto o consulta dada a un modelo de IA. Es como proporcionar un punto de partida o dirección para que la IA genere texto, traduzca idiomas, escriba diferentes tipos de contenido creativo y responda a sus preguntas de manera informativa.

Por ejemplo:

-

"Escribe un poema sobre un robot explorando el océano".

-

"Trata 'Hola, cómo estás?' en español".

-

"Explain computación cuántica en términos simples".

Todos estos son los avisos que guían a la IA para producir una salida específica.

Utilizando la instrucción de la llama de Meta , puedes construir varias herramientas en torno a las aplicaciones que se mencionan en este artículo. Tweak the prompts basado en su caso de uso y usted estará listo para ir. -

Conclusión

En este artículo, exploramos el mundo de los modelos de lenguaje grande, proporcionando una comprensión de alto nivel de cómo funcionan y su proceso de entrenamiento. Ahondamos en los conceptos básicos de LLM, incluyendo recolección de datos, aprendizaje de patrones y ajustes, y discutimos las amplias aplicaciones de LLMs en varias industrias.

Si bien los LLM ofrecen un inmenso potencial, también vienen con desafíos como prejuicios, preocupaciones de privacidad, demandas de recursos e interpretabilidad. Abordar estos desafíos es crucial a medida que la IA continúa evolucionando e integrendo más profundamente en nuestras vidas.

También evidimos un vistazo a cómo puede empezar a trabajar con LLMs usando la biblioteca Replicate, mostrando que incluso modelos complejos como Llama3 70b-instruct pueden ser accesibles para los desarrolladores con las herramientas adecuadas.